В конце марта в новосибирском Академгородке прошла VI ежегодная международная научная конференция “Параллельные вычислительные технологии (ПаВТ) 2012”, посвященная развитию и применению HPC в различных областях науки и техники. Ее организаторами выступили Российская академия наук и Суперкомпьютерный консорциум университетов России.

У столь масштабных мероприятий (конференция длилась три полноценных дня, и в ее рамках прозвучало почти 100 экспертных выступлений) достаточно сложно выделить какую-то одну общую идею. Однако с известными оговорками можно считать, что тон ПаВТ в этом году задал заместитель директора Научно-исследовательского вычислительного центра (НИВЦ) МГУ им. М. В. Ломоносова Владимир Воеводин со своим докладом с говорящим названием “Суперкомпьютерный мир: количество и качество”.

Как оценивать развитие HPC?

Открывая пленарную часть ПаВТ, г-н Воеводин отметил, что о количественных показателях суперкомпьютинга достаточно просто судить по различным рейтингам, ранжирующим вычислительные системы по их производительности. Если речь идет о России и СНГ, то наиболее полное представление об этом рынке дает рейтинг Top 50, каждые полгода составляемый НИВЦ МГУ и Межведомственным суперкомпьютерным центром (МСЦ) РАН. Презентация его 16-й по счету редакции состоялась как раз на конференции, однако долго ее комментировать г-н Воеводин не стал. Дескать с количественными показателями HPC и так все достаточно ясно: новые системы сменяют старые (в рейтинге 19 новых кластеров, включая модернизированные за последние полгода), их суммарная пиковая производительность растет, а реальная (на тесте Linpack) все больше от нее отстает, что свидетельствует об очевидном усложнении систем.

Что же касается качественных показателей рынка, то здесь, по мнению г-на Воеводина, все гораздо сложнее — необходимо учитывать множество различных критериев. В качестве примера была рассмотрена работа суперкомпьютерного комплекса МГУ, где основой является отечественная система компании “Т-Платформы”, лидер Top 50 — кластер “Ломоносов”, чья пиковая производительность после недавней модернизации выросла с 1373,06 до 1700,21 Тфлопс, а на тесте Linpack с 674,1 до 872,5 Тфлопс. По словам г-на Воеводина, в настоящий момент ресурсами комплекса пользуется более 500 научных групп. Это весьма внушительная цифра, однако еще более примечательным является тот факт, что в рамках самого университета вычисления осуществляют уже 24 подразделения МГУ. По наблюдениям г-на Воеводина, когда речь заходит о целевых группах университетского суперкомпьютинга, традиционно в первую очередь вспоминают о химии и физике, биоинформатике и биоинженерии, потом идет вычислительная математика и инженерные науки, затем машиностроение и астрономия, и на этом фантазия теоретиков иссякает. В реальности же вычисления становятся востребованы все большим количеством разноплановых специальностей.

По данным г-на Воеводина, за прошлый год исследования на комплексе легли в основу 9 докторских и 45 кандидатских научных работ. При этом за успешные изыскания, базис которых составили результаты, полученные с использованием университетского суперкомпьютера, было присуждено 64 премии и награды различного уровня.

Другая обязательная сторона, которую, по мнению г-на Воеводина, необходимо учитывать при качественной оценке использования систем, — КПД. Он, как правило, весьма низок — зачастую при решении задачи загрузка центрального процессора составляет всего 5—8%, о чем пользователи даже не подозревают. Эту величину можно и нужно повышать, и для этого информация о значение КПД должна, как минимум, перестать быть тайной. По уверению г-на Воеводина, прозрачность работы суперкомпьютеров сейчас стала одной из целей специального российско-европейского проекта (консорциумов университетов с обеих сторон). В его рамках разрабатывается набор средств, инструментов, методов и технологий, которые позволят людям правильно относиться к своим задачам, покажут, что происходит с системой в динамике выполнения программ, а также предложат оптимальные решения.

Еще одна сторона университетского суперкомпьютинга — участие в учебном процессе. За прошлый год на кластерах МГУ в разной форме прошли подготовку 740 студентов. В пиковом режиме на “Ломоносове” за сутки было выполнено 13 тыс. учебных заданий (практикумов).

Отечественный рынок HPC

Приведенные выше примеры описывают лишь одну сторону суперкомпьютинга. В целом же помимо научной рынок имеет еще и промышленную составляющую. В разрезе количества и качества достаточно подробно на эту тему незадолго до ПаВТ высказался директор по развитию корпоративных проектов Intel в России и СНГ Николай Местер. По его словам, научная составляющая HPC, к которой относятся проекты построения крупных систем для академических и образовательных учреждений, обычно занимается исследованием и разработкой новых технологий вычислений, межсоединений, принципов и протоколов передачи данных между узлами, проверкой концепций масштабирования алгоритмов распараллеливания задач. Результатом тут является сам факт возможности достижения какого-либо результата, например построения самого крупного или самого энергоэффективного комплекса. Таких проектов обычно реализуются единицы на страну за год-два, так как построение “самых-самых” систем требует максимальных бюджетов (десятки миллионов долларов) и сил, новых знаний и/или исследований. Создать подобную систему за три-четыре месяца практически невозможно. Как правило, для качественного прорыва ее масштаб должен превосходить сегодняшних лидеров в 5—10 раз по какому-либо параметру. Среднее время жизни таких систем два-четыре года, и за это время их обычно успевают обновить и развить, что иногда изначально закладывается в бюджет. При этом подобные проекты являются дотационными, и вопрос о прямом возврате вложенных в них средств не ставится. Отдача осуществляется за счет получения новых знаний для экономики государства.

Как утверждает г-н Местер, одной из особенностей создания крупных научных суперкомпьютерных систем является определенная однобокость их параметров. В итоге недостаток памяти на ядро, несбалансированность межсоединений или систем хранения данных ведут к тому, что многие “передовые” комплексы остаются невостребованными с точки зрения реального расчета как научных, так и промышленных приложений. Конечно, на этом HPC-общественность тоже учится, но это весьма дорогое удовольствие.

Второй составляющей рынка являются системы для нужд промышленности и государственных учреждений. Они обычно базируются на достижениях одно- или двухлетней давности, полученных в научных проектах. Как правило, вендор сначала создает некую уникальную систему для нужд науки, а потом по результатам эксплуатации либо тиражирует решение, либо отказывается от него как от бесперспективного. В этом, по мнению г-на Местера, и заключается вклад научных суперкомпьютерных проектов в экономику страны. И важным тут является доступ промышленности к получаемым технологиям.

Масштабы промышленных систем обычно в 5—20 раз меньше самых крупных научных кластеров — как по стоимости, так и по вычислительной мощности. Они являются инструментом для создания конечного высококонкурентного продукта и создаются под флагом надежности, проработанности алгоритмов, применения стандартных технологий и ПО. Внедряются они медленно, но после запуска работают достаточно долго — как минимум три-пять лет. Их обновление происходит редко; зачастую их заменяют целиком, так как эксплуатация старых систем обходится существенно дороже новых.

Крупных и средних промышленных решений в год создается примерно три-пять, мелких в два-три раза больше. Как отмечает г-н Местер, эти системы, к сожалению, далеко не всегда участвуют в рейтингах, поэтому лидеров определить сложно. На сегодняшний день публичные передовики находятся в диапазоне 15—40 Тфлопс пиковой производительности.

Если говорить о динамике роста рынка, то, как считает г-н Местер, именно в промышленности (авиации, двигателестроении, автопроме, судостроении, создании цифрового контента и пр.) в основном и будет происходить количественный и качественный прирост суперкомпьютинга в ближайшие три-пять лет. (Разумеется, при сохранении декларируемых сегодня приоритетов развития экономики страны.)

Актуальная конкретика

О каких бы секторах рынка HPC ни шла речь, при наращивании мощностей систем все более актуальным становится вопрос энергоэффективности. Ближайший знаковый рубеж — создание машины экзафлопсного уровня — ориентировочно будет преодолен в 2018—2019 гг. К тому времени сегодняшние технологии существенно разовьются, однако первые инсталляции, по расчетам экспертов, все равно станут потреблять не менее 66 МВт, в то время как с легкой руки министерства энергетики США базовым стандартом для экзафлопса является потребление на уровне 20 МВт. Нужны какие-то принципиальные технологические новшества, но, по словам Николая Местера, пока что их не видно. Соответственно сейчас индустрия занимается технологической оптимизацией уже существующих наработок, и данный процесс, уверяет г-н Местер, идет по трем направлениям: повышение производительности на доллар, на ватт и на квадратный метр.

Разные компании борются за энергоэффективность по-разному. Упоминавшаяся выше компания “Т-Платформы” большие надежды возлагает на гибридность — сочетание классической архитектуры Intel x86 с графическими ускорителями.

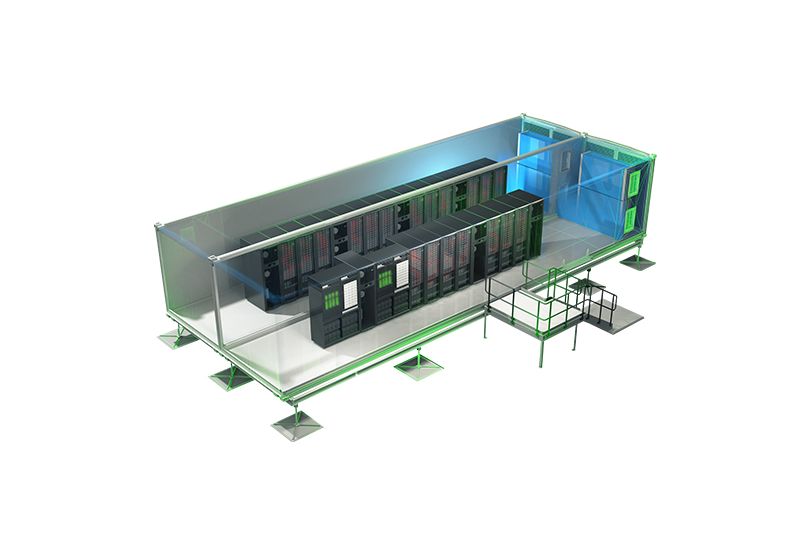

Другой отечественный поставщик решений, компания РСК, чьи успехи в контексте новой редакции Top 50 были особо отмечены Владимиром Воеводиным (четыре инсталляции, вошедшие в список, против двух полгода назад), к гибридности относится скептически. Главную ставку в вопросах оптимизации технологий РСК делает на жидкостное охлаждение для стандартных и массово доступных серверных плат (различных производителей) на базе процессоров Intel Xeon, изначально созданных для традиционных систем с воздушным обдувом электронных компонентов. Данная технология реализована в собственной архитектуре компании, получившей название “РСК Торнадо”. Ее применение позволило добиться выдающихся показателей: вычислительная плотность — 74 Тфлопс/м2, коэффициент эффективности использования электроэнергии — 1,06 (т. е. не более 5,7% энергопотребления системы расходуется на ее охлаждение), сокращение эксплуатационных расходов до 60% (экономия затрат на электроэнергию в денежном выражении).

РСК, как и другие перспективные, с точки зрения Intel, компании, имеет возможность интегрировать в свои разработки новейшие процессоры мирового лидера еще до их официального анонса. Не стал исключением и Intel Xeon E5-2690. Его важной особенностью является то, что в нем технология Intel Turbo Boost задействует все ядра, способна работать все время и обеспечивает прирост тактовой частоты до 400 МГц на тесте Linpack (реальная частота 3,3 ГГц). Разумеется такое увеличение производительности возможно лишь в случае эффективного охлаждения, и “РСК Торнадо” с этой задачей справляется. В контексте упоминавшегося г-ном Воеводиным увеличения общего для индустрии отставания реальной производительности от пиковой, примечателен тот факт, что коэффициент вычислительной эффективности, который обеспечивает второе поколение этой платформы, достигает 92% (на Linpack).

Отдельно нужно отметить, что в своих официальных заявлениях специалисты Intel воздерживаются от утверждений, что экзафлопсные системы станут охлаждаться именно жидкостью. Но то, что теме эффективного отвода тепла в компании уделяют самое пристальное внимание, вполне очевидно. Причина проста: за счет увеличения эффективности охлаждения можно будет сэкономить порядка 20 МВт, что в пересчете на деньги даст примерно 30 млн. евро в год (по сегодняшним ценам на электроэнергию в Германии).

Напоследок стоит упомянуть тот факт, что, согласно мировому рейтингу Green 500, среди российских систем самой энергоэффективной на данный момент является именно суперкомпьютер с жидкостным охлаждением — кластер РСК в Южно-Уральском государственном университете, который Николай Местер называет примером возвращения к “реальным ценностям” при построении крупных научных систем, когда пиковые терафлопсы не являются главным приоритетом.