Новейший и самый быстрый графический процессор Nvidia под кодовым названием Blackwell уже готов, и в этом году он ляжет в основу планов компании в области искусственного интеллекта, сообщила Nvidia.

Чип отличается повышенной производительностью по сравнению со своими предшественниками, в том числе самыми востребованными GPU H100 и A100. Клиенты требуют большей производительности в области ИИ, и новинка должна преуспеть, поскольку неудовлетворенный спрос на более производительные графические процессоры растет.

GPU Blackwell может обучать модели с 1 трлн. параметров, заявил Ян Бак, вице-президент Nvidia по высокопроизводительным и гипермасштабируемым вычислениям. Системы, располагающие до 576 графических процессоров Blackwell, могут быть сопряжены для обучения моделей с несколькими триллионами параметров.

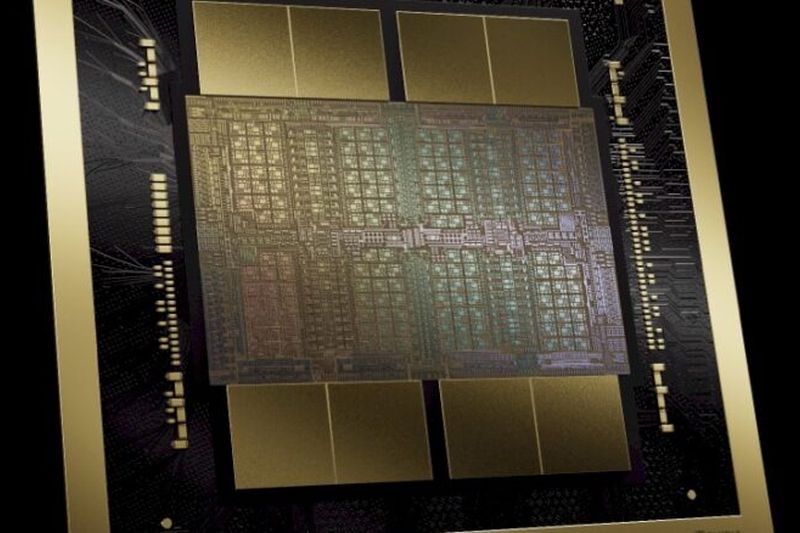

Графический процессор изготовлен по

ИИ — процесс, требующий много памяти, и данные необходимо временно хранить в оперативной памяти. Blackwell оснащен 192 Гб памяти HBM3E, как и прошлогодний GPU H200.

Nvidia сосредоточилась на масштабировании систем путем увеличения количества графических процессоров Blackwell, чтобы справиться с более крупными задачами ИИ. По словам Бака, новинка позволит расширить масштабы применения графических процессоров в дата-центрах для ИИ-нагрузок до уровня свыше 100 000 GPU.

Blackwell обеспечивает «20 Пфлопс ИИ-производительности на одном GPU», — утверждает Бак. Он предоставил ориентировочные цифры производительности, призванные произвести впечатление, тогда как реальные цифры производительности остались недоступны. Однако вполне вероятно, что для измерения производительности Blackwell и достижения показателя в 20 Пфлопс Nvidia использовала новый тип данных FP4. Предшественник H100 обеспечивал производительность в 4 Пфлопс для типа данных FP8 и около 2 Пфлопс для FP16.

«Blackwell в четыре раза превосходит Hopper по производительности обучения, в 30 раз — по производительности вывода и в 25 раз — по энергоэффективности», — утверждает Бак.

Тип данных FP4 предназначен для выводов и позволяет быстрее обрабатывать небольшие пакеты данных и гораздо быстрее выдавать результаты. На нем достигается более высокая производительность ИИ, но меньшая точность. FP64 и FP32 обеспечивают более точные вычисления, но не предназначены для ИИ.

Графический процессор состоит из двух упакованных вместе модулей. Они взаимодействуют через интерфейс NV-HBI, который передает информацию со скоростью 10 Тб/с. Объем памяти HBM3E в Blackwell составляет 192 Гб, пропускная способность памяти — 8 ТБ/с.

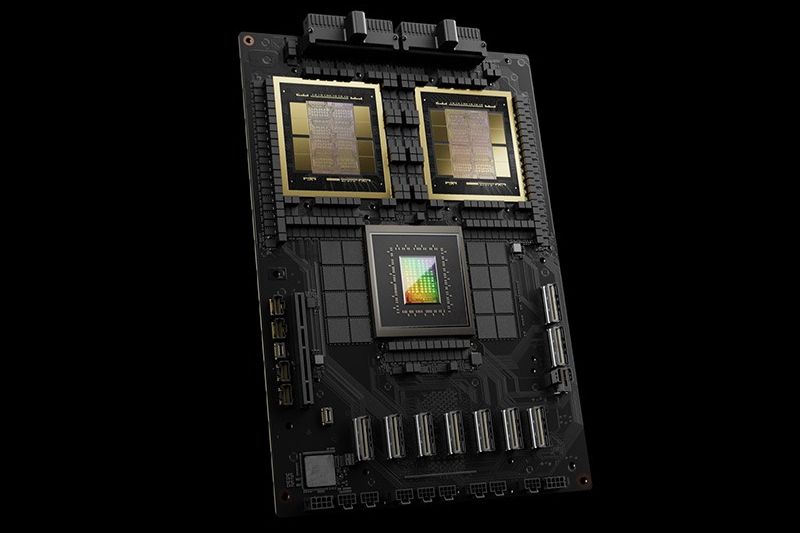

Nvidia также создала системы с графическими процессорами Blackwell и центральными процессорами Grace. Во-первых, это суперчип GB200, который объединяет два графических процессора Blackwell с процессором Grace. Во-вторых, это полноценная стоечная система под названием GB200 NVL72 с жидкостным охлаждением — в ней 36 суперчипов GB200 и 72 графических процессора.

Система GB200 NVL72 обеспечивает производительность 720 Пфлопс при обучении и 1,4 Эфлопс при выводе. Она может поддерживать модели с 27 трлн. параметров. Графические процессоры соединены между собой с помощью нового интерфейса NVLink, пропускная способность которого составляет 1,8 Тб/с.

Системы GB200 NVL72 появятся в этом году у облачных гиперскейлеров.

Совместно с AWS компания создает суперкомпьютер для ИИ под названием Project Ceiba. «Мы модернизируем его до уровня Grace-Blackwell, поддерживающего 20 000 GPU, и теперь он будет обеспечивать ИИ более 400 Эфлопс», — говорит Бак. Система будет запущена в конце этого года.

Nvidia также анонсировала суперкомпьютер для ИИ под названием DGX SuperPOD, состоящий из восьми систем GB200 — или 576 GPU — которые могут обеспечить ИИ-производительность 11,5 Эфлопс для FP4. Системы GB200 могут быть подключены через интерфейс NVLink, который позволяет поддерживать высокую скорость обмена на небольшом расстоянии.

Кроме того, DGX SuperPOD может объединять десятки тысяч графических процессоров с помощью сетевого стека Nvidia Quantum InfiniBand. Пропускная способность этой сети составляет 1800 Гб/с.

Nvidia также представила еще одну систему под названием DGX B200, в которую входят чипы Intel Xeon

Системы DGX появятся рынке в конце этого года.

В графических процессорах Blackwell и системах DGX предусмотрены функции предиктивного обслуживания, позволяющие поддерживать их в отличной форме, говорит Чарли Бойл, вице-президент Nvidia по системам DGX: «Мы ежесекундно отслеживаем 1000 точек данных, чтобы понять, как оптимально выполнить работу».

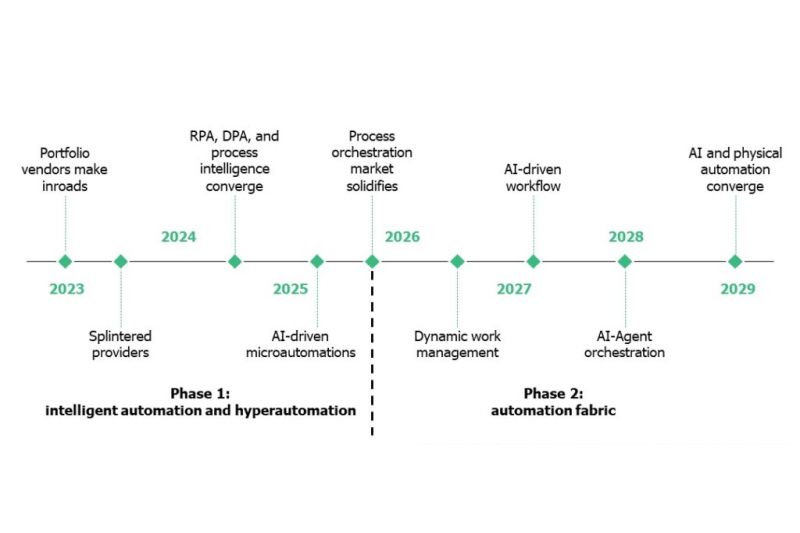

Nvidia также внедряет функции ИИ для предиктивного обслуживания. «У нас есть ИИ для предиктивного обслуживания, который мы запускаем на уровне кластера, чтобы видеть, какие узлы здоровы, а какие нет», — говорит Бойл. Если задание умирает, эта функция помогает минимизировать время перезапуска. «Для очень больших заданий раньше требовались минуты, а иногда — часы, теперь мы стараемся сократить это время до нескольких секунд», — говорит он.